搜索引擎,可以通過聯想詞使得人們在使用時更加的便利,但是與此同時,也帶來了一些麻煩。 人類有固有的思維盲區,讓他們在設計算法和流程的時候,實在是難以預料用戶會出現什麼樣的不當使用行為,導致什麼奇葩的結果。

有媒體報導,通過搜索引擎,可以找到一些“相約自殺”的QQ群、微信群等,成為有些年輕人自殺的誘因。 搜索引擎方面自然對這種聯想詞功能的問題責無旁貸,然而媒體和公眾花樣翻新的測試,總是讓產品設計者防不勝防。

為了讓我們更方便的使用搜索,聯想詞是必然要加入的一項功能。 而對人們的意圖進行聯想和預測,也是未來人工智能語音助手變得更好用的基礎前提。 但是,人類固有的思維盲區,讓他們在設計算法和流程的時候,實在是難以預料用戶會出現什麼樣的不當使用行為,導致什麼奇葩的結果。

往往只有在媒體曝光,公眾關注以後,他們才能知道運算的結果如何,然而此時,錯誤已經鑄成。

一、為您推薦

年輕人在網上相約自殺的行為,中外都有。 在中國,主要的網絡平台載體就是QQ群、微信群等地。 幾天前《法制晚報》報導,又有三名青年通過QQ群“相約自殺”成功。

看到孩子遺體的父親在悲慟欲絕之餘,還質問網絡平台說:

“聊了那麼久,網站看不到嗎?網絡平台沒有審核麼?不承擔任何一丁點的責任麼?”

不管事實上看不看得到,從公司主觀層面,騰訊當然都要說看不到用戶的聊天記錄。 這一點可能不會遭遇什麼異議,你當然也不希望自己在群裡剛說了一句話,五分鐘後就有警車呼嘯而至什麼的吧。

不過,在《法制晚報》的報導中,記者在百度上搜索“自殺群”關鍵字,就能非常容易地找到很多QQ群的號碼。 公開展示的信息,和私密的群聊是兩碼事。

報導稱:結果頁面不僅有聊天記錄截屏。 相關新聞報導,而且每次點擊結果後,都會通過聯想詞自動“為您推薦”一些關鍵字,包括“約死微信群2018、2018相約死亡群、2018想死扣扣群”等。

筆者小時候曾經幫不太懂電腦的同學和家長找過資料,時常被詢問 “為什麼我這麼半天搜不出來,你一搜就有了”, 這實在三言兩語很難講清楚。

但是,很顯然百度的這些關鍵詞聯想功能,給了一些可能不太熟悉搜索引擎語法的用戶機會,讓他們可以獲得更精準的結果。

二、防不勝防

記者向百度反映之後,百度已經修正了相關檢索結果。 現在你再搜索“自殺群”時,就不再顯示帶有具體群號碼的討論,基本上看到的都是相關事件的新聞,持續十幾二十幾頁都是這樣。

而且,讓航通社感受頗深的是,跟“相約自殺”有關的搜索結果清理工作,在今天(6月26日)持續一整天都在不斷進行。

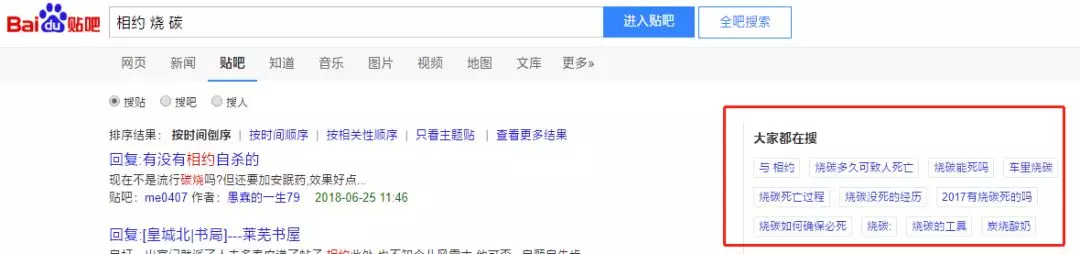

今天上午,航通社測試在百度貼吧搜索框當中打“相約自殺”,並選擇“全吧搜索”,還會發現帶著QQ群號碼的一些帖子;“相約燒炭”“燒碳”等一些 變種也有帖子存在。 但到了下午4點左右再測試,這些頁面刷新之後基本都被清理了。

然而,媒體曝光的問題修改起來總是容易的。 進一步操作的話就會發現,還有一些“高危”的短句搜索結果未作處理。

在貼吧搜索“相約燒炭”,旁邊的“大家都在搜”提示了“燒炭多久可致人死亡”、“車裡燒碳”、“燒碳如何確保必死”、“2017有燒碳死 的嗎”這些短語。

筆者相信它們的形成機制,和報紙記者測試出現的“約死微信群2018”等是一樣的,機器不太可能無中生有地造出這些排列組合。 每一個關鍵字的後面,很大程度上都可能有不止一個真人親自打出過這些詞。

只要簡單想想,就令人後背發麻。

三、是不是有專門的員工盯著

在知乎,有關於百度的三個“經典問題”:

“百度作了哪些惡?”

“為什麼有人說百度以一己之力全面降低了中國互聯網體驗?”

“為什麼老師說‘百度搜索不是什麼正經的東西’?”

在這些問題下的數千個回答中,有些提到的現象現在再看,已經無法重現。 而有時在某個回答成為熱門之後很短時間,其中提到的不妥當的搜索結果就會被清理。

筆者一度懷疑,有專門的百度員工盯著這些“招黑”的帖子和媒體報導。 不過有自稱的百度員工回帖說,一般他們都是路過看到,順手貼進內網論壇,也通過這一渠道報了很多Case。

實際上,面對一部分搜索結果的Bug(特別是和盈利不明顯掛鉤的問題),百度並不是毫無作為,同時也樂於將一些搜索結果的改善大舉宣傳,作為企業履行社會責任的一部分錶現。

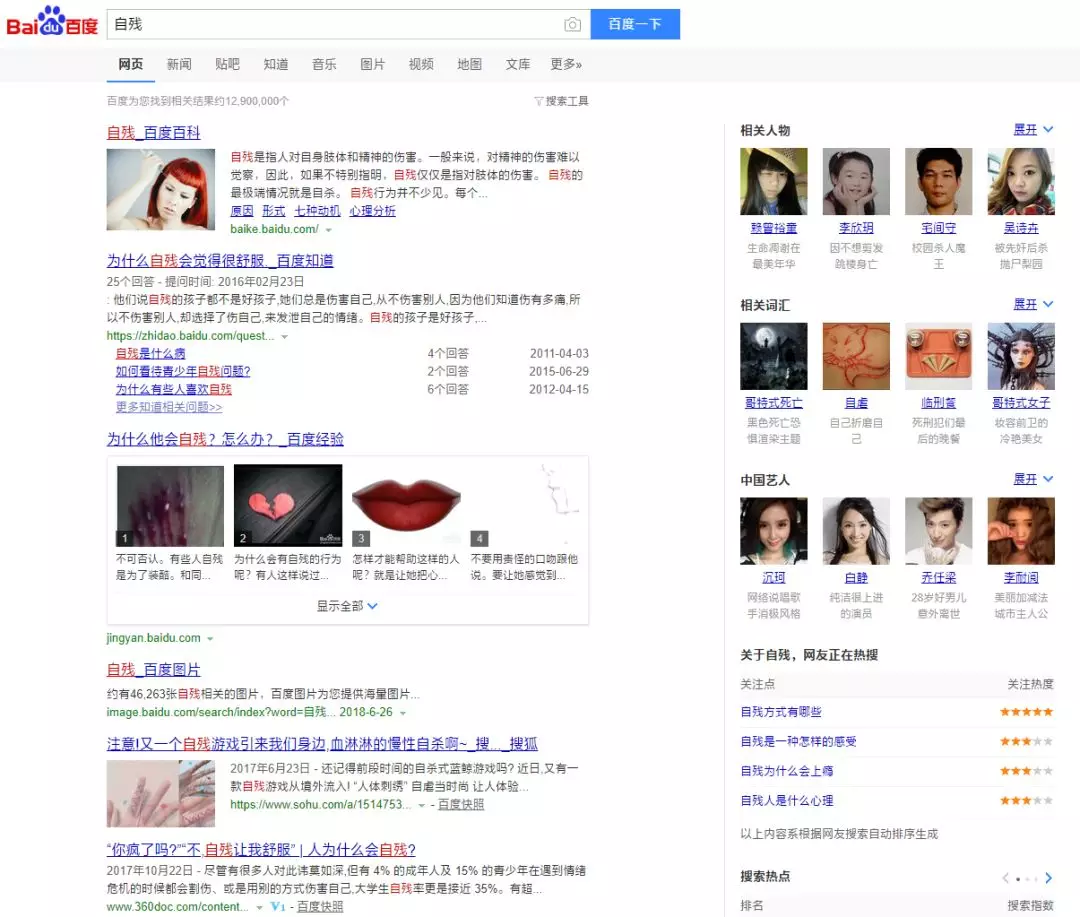

具體到“自殺”問題,百度和國內其他搜索引擎,均已和國內相關的心理干預機構建立了合作關係。 在一些比較容易想到的詞語,比如說:“自殺”,“我想自殺”這類關鍵詞結果頁,都會出現求助熱線電話號碼,以及求助方式,基礎知識等等。

至少有一部分人選擇自殺時,並不是經過深思熟慮的,只是一時間想不開。 與此同時,他又沒有接觸過關於自殺的一些基礎知識,包括死亡的代價,尋死的疼痛,無法挽回和來不及後悔的具體含義。

也許,如果他們有機會了解到相關的知識,那麼他可能就會被嚇到,或者被勸阻,從而重新認真的思考自己這一決策是否合理。

但是,這個關鍵字提醒功能,並未涵蓋“自殺群”、“相約自殺”等詞,也沒有覆蓋所有的“死法”,比如:“上吊”、“跳樓”有,但“燒炭”、 “安眠藥”沒有。

這很顯然與百度的分詞策略有很大關係,“自殺”關鍵字的相關頁面無疑是人工干預的結果,而產品經理頭腦風暴以後想不到的一些詞,就只會由系統自動展開聯想。

具體到“自殺群”這個詞,因為在近一兩天產生了大量新聞和轉載,全國轉載媒體達到幾十家,所以這可以組成一個自動的新聞專題。 我相信記者寫稿時看到的結果頁肯定不是這個樣子,但是已經沒有辦法去查證了。

當“自殺群”關鍵詞被系統認為是新聞熱點的時候,在頁面右側的推薦結果當中,就會提示“相關人物”——最近有什麼名人自殺了,以及其中包含的“知名演員”。

雖然看不到具體的QQ群號,但是顯示的是有多少名人和自己一樣,也選擇了自我了斷,這可能對有自殺念頭的人來說,並不是一個非常正面的激勵。

此外,也有網友指出,百度雖然對“自殺”實施了乾預,但對造成後果同樣很嚴重的“自殘”卻沒有乾預。 現在(6月26日下午4點)搜索“自殘”,第二條結果是有人問“為什麼自殘會覺得很舒服”。

四、盲區如何形成

如此看來,搜索引擎聯想詞惹出的麻煩,恐怕不能靠產品設計上事先根治,多數情況下是發現一個整改一個,跟打地鼠一樣。 是什麼導致了這樣的結果呢?

首先, 與“自殺”相關的這一系列詞語,可以說在整個搜索處理流程中,並沒有達到一個極端重要的優先級, 換句話說就是還沒有成為“敏感詞”。

因為如果將“自殺”也設置為不可觸碰的最高等級詞語,你會發現自己連發消息,甚至發諧音字火星文代替都很困難。 如果很多人自殺念頭只是一閃念,看這麼麻煩,也許就偃旗息鼓了。 然而,這樣做會很大程度上影響我們的日常交流,給人們帶來的不便,已經超出了封禁可能帶來的好處。

但更重要的是:我們尋求結果的過程,從事後來看可以說是非常簡單,但是事前想要從零開始去想,那就非常困難。

這就像我們去閱讀一篇構思精巧的偵探小說一樣。 沒有經驗的讀者,不知道這種小說會有什麼樣的套路,面對謎題的時候會是一頭霧水的。 但是當最後真相終於揭曉的那一刻,我們再把它還原回去,就會感覺一切線索原來都預先設置好了,草蛇灰線的埋伏都是在情理之中的。

那麼,為什麼我們這麼笨,就沒有想到呢?

其實不是我們笨,而是一些我們日常可能思維形成的慣性或者定勢,對我們造成了誤導。

小時候,老師用一個“棉花糖實驗”,教給我們做事要忍耐,要有毅力,抵禦誘惑的道理。 好像在有些地方,也被誤傳為“棒棒糖實驗”什麼的。 實驗內容是給一些孩子們每人一塊棉花糖,如果他們忍住15分鐘不吃掉糖,就能再吃一塊。 當然,馬上就吃也沒關係,但是不會有獎勵。

大多數小孩都忍不住吃掉了,或者搞小動作吃了一點點,自以為沒被發現,最後能堅持15分鐘沒吃糖的孩子只有一小部分。 然後呢,這一小部分孩子長大後果然堅毅勇敢有耐心,走上人生巔峰。

然而,《大西洋月刊》雜誌最新刊登的一篇文章介紹了紐約大學和加州大學一項共同研究的結果,讓人大跌眼鏡——這項原本進行於1990年的“棉花糖實驗”的結論可能有誤 。

確實有少數孩子比其他孩子更能堅持15分鐘,以拿到雙份的棉花糖,但這並不是因為他們更有毅力——而是因為他們家境較好,小時候就能經常吃到好東西, 所以並不認為棉花糖是一個稀罕物。

我讀到之後既震驚又奇怪,為什麼之前我只是被動的接受了老師指定的結論,或者是“標準答案”? 為什麼我都沒想到從另外的角度去看,或者懷疑它?

我想,對於百度的工程師和產品經理們來說,他們顯然也不是全知全能的。 說到給關鍵字添加溫馨提示,他們只能是想到“自殺”,以及“我要自殺”、“我想自殺”,沿著這樣的路徑去聯想。

他們不可能想到,“自殺”後面還可以跟著“QQ群”,或者是“相約”,或者是細緻入微地採用自然語言詢問怎麼自殺最快且不痛苦。

五、人人都是義務測試員

歷史上,搜索引擎因聯想功能而受到的抨擊,簡直是舉不勝舉。

2009年6月,國家有關部門批評谷歌中國存在“大量淫穢色情和低俗信息”,使“大量境外互聯網上的淫穢色情信息通過該網站傳播到我國境內”。

在《焦點訪談》節目中,有關部門演示了谷歌網站聯想詞搜索存在提示黃色信息的問題。 例如:在谷歌中國中輸入“兒子”,下面卻出現了例如“兒子母親不正當關係”等十幾個選項。

事件成為谷歌宣布退出中國業務運營的直接導火索,此後有網友指出,在報導播出前幾天,相關詞彙的搜索量異常驟增,導致該詞彙成為熱門關鍵字,因此可以進入聯想詞列表 的前列。

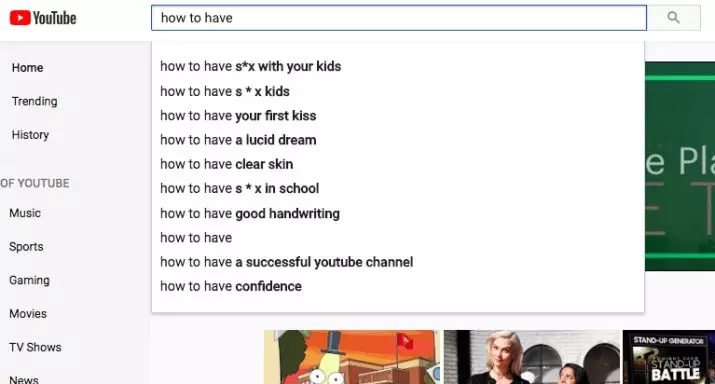

- 直到現在,谷歌、Facebook、Twitter等網絡平台所遭遇的跟關鍵詞、自動聯想推薦功能有關的無妄之災,也依然是層出不窮。

- 2016年12月,在谷歌搜索框輸入“猶太人是”時,會顯示“猶太人是邪惡的”聯想詞。

- 2017年11月,在YouTube搜索“how to have”時,會顯示“how to have s*x with your kids”(如何與你的孩子發生*關係,原文就有*號)。

2018年2月,谷歌搜索會提供這樣一些聯想詞:“伊斯蘭主義者不是我們的朋友”、“希特勒是我的英雄”、“女權主義者是性別歧視”、“白人至上是好的”、“ 全球變暖是假的”。

媒體展開了憤怒的質問:

為什麼像我們記者這樣的普通用戶,都能一眼就發現的東西,你們谷歌有那麼高明的技術手段,卻遲遲不能發現?

如同上面我們說過的一樣,雖然算法是普遍存在的,然而人的思維是有盲區的。 所以,算法優化的方向也是由人來指定的,那麼它也只會把一個已經知道的位置去掃描得事無鉅細,卻完全管不到它和它的設計者可能想像不到的地方。

自動推薦是機器學習最典型的應用,而這個“黑箱子”裡面一向以人們不能掌握其具體運轉機製而著稱。 就算歐盟通過GDPR立法,逼迫廠商公開算法細節,恐怕那公開出來的,也是沒人看的懂的天書。

長遠來看,解決混沌的方法必須是還以混沌。 也就是說,用機器學習去對抗隨機Bug,是解決所有未來這些聯想問題的唯一一個看起來可行的途徑。

具體到搜索關鍵字聯想,應對不當聯想的方法,除了人工標記——就連谷歌在回應媒體報導時,都只能說用到這個方法——可能就是要採用類似神經網絡翻譯的手段:通過分 拆和描述一個關鍵詞、短句的具體特徵,計算某類詞彙(以及其錯別字變體)跟另一些詞一同出現的概率,並嘗試通過人工抽樣檢查等方式下判斷來訓練機器。

如果機器學習實在到不了這種程度,一個非常簡單的方式就是一禁了之。

例如:任何出現QQ群號碼的帖子——也就是“QQ、秋秋、V信”等詞語,後面加上九位或十位數字——或者是手機號這類的信息,如果和“自殺” 、“燒碳”連綴的話,我們根本就不讓它出現在百度搜索結果裡,可不可以?

還是說起來容易,做起來難。 全面禁止容易“誤傷”,為用戶帶來不便,而且出了問題以後,對系統改動的斷點越多,查找問題源頭時就越麻煩,最後可能越改越糟。

我願意從比較善良的角度思考,相信百度、谷歌等這些提供算法推薦的企業,並沒有因為出現時有發生的負面消息,而一口氣關閉推薦功能,初衷是進一步改善和優化搜索結果,以至於 讓它不斷的接近人類的思維可以達到的理想境界。

在這種改善產品的過程中, 搜索引擎事實上推出了一個不完美的“半成品”,把所有使用這個功能的用戶、媒體等等,都當成是其測試部門的“編外”工作人員。 每一次搜索異常,都是在向開發者反應一個錯誤的測試結果,或者是示範一種計劃之外的錯誤的用法。

對於程序員來說,他們可能學到的很多項重要的道理當中,其中一條就是,永遠不要去試圖規範用戶該做什麼,不該做什麼,他總能找到你意想之外的使用方式。

然而, 如果你試圖把所有的用戶當做不花錢的測試員,這樣做的結果就是你必須要付出金錢之外的代價。

當媒體以及社會輿論發現你這些錯誤,並且在社交渠道廣為流傳的時候,這就不是你能夠靠給媒體們發工資能解決的問題了——可能很多年之後,關於這個搜索引擎各種不 靠譜的印象,還是會繼續流傳。

作者:航通社,微信公眾號: ID:lifeissohappy, 微博 @lishuhang

本文由 @航通社 原創發佈於人人都是產品經理。 未經許可,禁止轉載

題圖來自 Pixabay,基於 CC0 協議

酷播亮新聞

酷播亮新聞